QualcommがAIアクセラレータ「AI200/AI250」を発表、データセンター向けAIチップ市場に参入へ

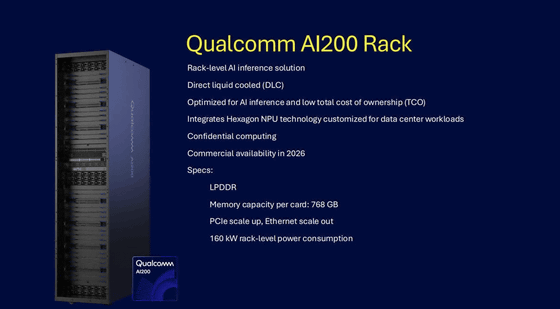

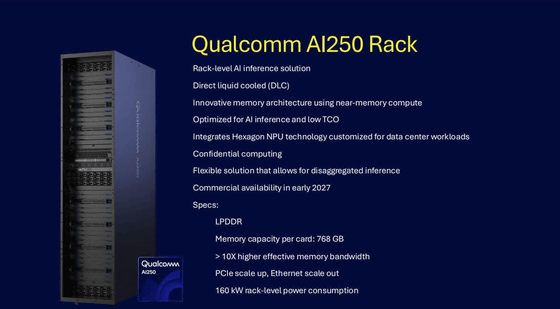

Qualcommが、データセンター向けの次世代AI推論最適化ソリューションとして、AIアクセラレーターカードを含むラックソリューション「Qualcomm AI200」と「Qualcomm AI250」を発表しました。これらはラック規模での性能と優れたメモリ容量を提供し、AI推論において業界をリードする総所有コストの低さを実現します。

Qualcomm Unveils AI200 and AI250—Redefining Rack-Scale Data Center Inference Performance for the AI Era | Qualcomm

https://www.qualcomm.com/news/releases/2025/10/qualcomm-unveils-ai200-and-ai250-redefining-rack-scale-data-cent

Qualcomm Launches AI250 & AI200 With Huge Memory Footprint For AI Data Center Workloads

https://hothardware.com/news/qualcomm-ai250-ai200-huge-memory-footprint-ai-data-center

Qualcomm is turning parts from cellphone chips into AI chips to rival Nvidia | The Verge

https://www.theverge.com/news/807078/qualcomm-ai-chips-launch-hexagon-npus

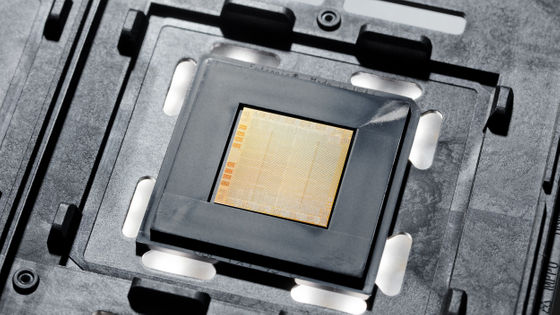

AI200もAI250もチップ単体ではなく、冷却装置や電源もすべて1つのラックに収めたラックソリューションという形で発表されました。熱効率のための直接液冷、スケールアップのためのPCle、スケールアウトのためのイーサネット、および安全なAIワークロードのための機密コンピューティングを特徴とし、ラック単位の消費電力は160kWです。

AI200は、大規模言語モデルやマルチモーダルモデルなどのAIワークロードに最適化された性能を提供し、低い総所有コストを実現するために設計された、目的特化型のラックレベルAI推論ソリューションです。カードあたり768GBのLPDDRをサポートし、高いメモリ容量と低コストを実現することで、AI推論における優れた拡張性と柔軟性を提供します。AI200は、2026年に商用提供される予定です。

AI250は、(PDFファイル)ニアメモリコンピューティングに基づく革新的なメモリアーキテクチャを採用し、AI推論ワークロードに対して、有効メモリ帯域幅を10倍以上高め、消費電力を大幅に低減することで、効率と性能に飛躍的な進歩をもたらすとのこと。これにより、ハードウェアの効率的な利用を可能にする分離型AI推論(disaggregated AI inferencing)を実現し、顧客の性能とコストに関する要求を満たすとQualcommはアピールしています。AI250は、2027年初頭に商用提供される予定です。

QualcommのAIプロセッサは、NVIDIAやAMDのGPUと同様に、最大72個のチップが単一のコンピューターとして機能するラック内で動作できます。これらのAIプロセッサは、モバイルデバイスやノートパソコン向けのチップに搭載されている、QualcommのHexagon NPUに基づいて開発されているとのこと。

AI200とAI250は、主に携帯電話やノートパソコン、タブレット、および通信機器用のプロセッサを製造してきたQualcommにとって新しい挑戦であり、NVIDIAやAMDといった競合企業がひしめくデータセンター向けAIチップ市場への新たな進出を示すものでもあります。

すでにQualcommは、サウジアラビア政府系ファンドが出資するAI企業「Humain」がすでにAI200およびAI250のラックソリューションを200メガワット規模で購入していることを明らかにしています。

.@Qualcomm and @HUMAINAI are deploying the world’s first fully optimized edge-to-cloud AI infrastructure in Saudi Arabia, including 200MW of AI200 and AI250 rack solutions—accelerating scalable, high-performance inferencing for enterprises and government. https://t.co/GW3DSXGgQc pic.twitter.com/QQ5vlhIH0B

— Cristiano R. Amon (@cristianoamon) October 27, 2025

Qualcomm Technologiesの技術企画・エッジソリューション・データセンター担当上級副社長兼ゼネラルマネージャーであるドゥラガ・マラディ氏は、「AI200とAI250により、Qualcommはラック規模のAI推論で可能なことの再定義を進めています」と語り、「私たちの革新的な新しいAIインフラストラクチャソリューションは、前例のない総所有コストで生成AIをデプロイすることを可能にすると同時に、現代のデータセンターが要求する柔軟性とセキュリティを維持します」と述べました。

また、マラディ氏は、「Qualcommの豊富なソフトウェアスタックとオープンなエコシステムのサポートにより、最適化されたAI推論ソリューション上で、既にトレーニングされたAIモデルを開発者や企業が統合、管理、拡張することがこれまでになく容易になります。主要なAIフレームワークとのシームレスな互換性とワンクリックモデルデプロイにより、Qualcomm AI200とAI250は、摩擦のない導入と迅速なイノベーションのために設計されています」とコメントしました。

・関連記事

Qualcommがオープンソースプラットフォームを手がけるArduinoを買収 - GIGAZINE

Qualcommがスマートグラス向けチップの「Snapdragon AR1+ Gen 1」を発表、AIのローカル処理を念頭に設計 - GIGAZINE

GoogleとAnthropicがクラウドパートナーシップを正式発表、100万台以上のTPUの利用拡大でコンピューティング能力増大 - GIGAZINE

OpenAIがAI処理チップを独自開発するべくBroadcomと戦略的パートナーシップを締結、10ギガワット級のチップを生産予定で契約金は数千億円 - GIGAZINE

Qualcommがスマートグラス向けチップの「Snapdragon AR1+ Gen 1」を発表、AIのローカル処理を念頭に設計 - GIGAZINE

Qualcommが次世代MR向けチップ「Snapdragon XR2+ Gen 2」を発表、GoogleとSamsungが搭載デバイスを開発中 - GIGAZINE

Xiaomiが完全ワイヤレスのARグラス「Xiaomi Wireless AR Glass」を発表、ジェスチャー操作&スマホとNFCでタップするだけでペアリング - GIGAZINE

・関連コンテンツ

in AI, ハードウェア, Posted by log1i_yk

You can read the machine translated English article Qualcomm launches AI accelerators 'AI200….