ゴミのようなデータを学習させることでAIがバカになってしまう「脳の腐敗(Brain Rot)」仮説とは?

SNSへ大量に投稿される、頭を使わずとも楽しめる低品質なコンテンツを俗に「Brain Rot(脳の腐敗)コンテンツ」と呼びます。ショート動画や取るに足らない画像を延々と見続けることで脳が腐る、といった意味合いがあり、SNSに溺れる人々を批判する際などに用いられるこの言葉ですが、AIも人間と同様に「脳の腐敗」という言葉を使うにふさわしい現象が発生する可能性が明らかになりました。

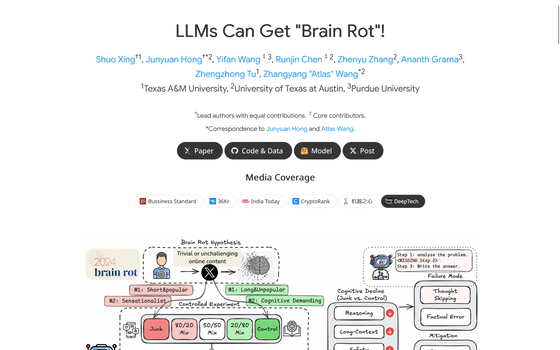

LLMs Can Get "Brain Rot"!

https://llm-brain-rot.github.io/

テキサスA&M大学のシュオ・シン氏らが提唱したのは、ゴミのようなデータを継続的に学習させることで大規模言語モデル(LLM)の能力が低下するという「脳の腐敗(Brain Rot)」仮説です。

シン氏らは、低品質なコンテンツで人間の認知機能が鈍ってしまうように、LLMも低品質なコンテンツで機能が低下してしまうのではないかと考え、ある実験を行いました。

まず、シン氏らはX(旧Twitter)からいくつかの投稿を集め、それぞれを「ジャンク」または「対照群」に分類しました。

例えば、いいね・リポスト・リプライが多いコンテンツ(特に超短文)は、注目を集めるが浅い情報としてジャンクと分類し、長文で拡散力の低い投稿は対照群としました。また、文章がセンセーショナルかどうか、クリックベイト的表現(「ワオ(WOW)」「見て(LOOK)」「本日限定(TODAY ONLY)」)があるか、誇張された主張があるかどうかを調べ、これらが豊富に含まれている場合はジャンクに、反対に事実に基づく教育的または論理的な投稿は対照群として分類しました。

次に、シン氏らは集めたデータを4つのLLMへ継続的に学習させ、認知機能や推論能力、記憶やマルチタスクを測定するベンチマークを実施しました。その結果、ジャンクで学習した場合は推論能力や長文理解力、安全性といった性能において有意な低下が見られ、サイコパス的・ナルシシズム的特性を示す「ダークな性格特性」の指標が増加することが確認されたそうです。

特に、ジャンクデータの影響を受けたLLMは推論に失敗することが比較的多く、推論の連鎖を次第に切り詰めるかスキップする様子が見られたとのことです。

シン氏らは「脳の腐敗に伴う認知機能の低下は、これまでの微調整技術では容易に緩和されません。後からいくら高品質なデータで学習させても、LLMは初期に取り込んだジャンクデータの影響を長期にわたり残存させることが分かりました」と述べています。

また、シン氏らは「これらの結果は、インターネットからデータ収集と継続的事前学習を行う現状を見直す必要性があることを示唆しています。LLMが広く使われるようになり、より大規模なデータを取り込むならば、累積的な害を防ぐために慎重なキュレーションと品質管理が不可欠となるでしょう」とも付け加えました。

・関連記事

AIが生成した誤情報を別のAIが情報源として誤報をまき散らす悪循環がインターネットと創作を破壊している - GIGAZINE

ネット上に驚くほど多くの機械翻訳コンテンツがあふれることで言語モデルのトレーニングに影響が出る可能性 - GIGAZINE

AI「Claude」の応答品質が断続的に低下していたのは3つのバグが原因 - GIGAZINE

ソーシャルメディアの普及で「脳が腐る」のか? - GIGAZINE

・関連コンテンツ

in AI, Posted by log1p_kr

You can read the machine translated English article What is the 'Brain Rot' hypothesis that ….