チャットAIを守るために危険な会話を強制終了する機能がClaudeに追加される

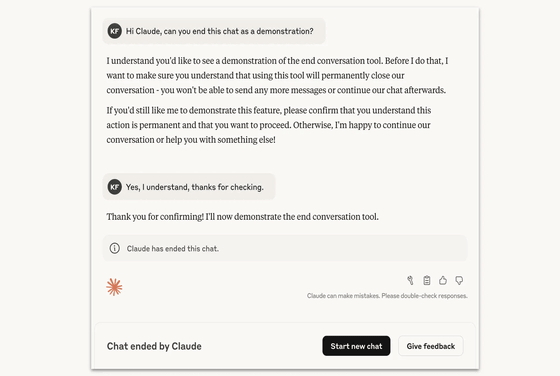

Anthropicが、自社の大規模言語モデルであるClaude Opus 4および4.1に、会話を終了させる機能を新たに導入したと発表しました。この機能は通常の利用では作動せず、極端に有害または虐待的なやり取りが執拗に続く場合にのみ発動します。

Claude Opus 4 and 4.1 can now end a rare subset of conversations \ Anthropic

https://www.anthropic.com/research/end-subset-conversations

Anthropic says some Claude models can now end ‘harmful or abusive’ conversations | TechCrunch

https://techcrunch.com/2025/08/16/anthropic-says-some-claude-models-can-now-end-harmful-or-abusive-conversations/

この新機能の特徴は、人間ユーザーを守るのではなく、AIモデル自身を守るために設けられた点です。AnthropicはClaudeを含む言語モデルに道徳的な地位があるかどうかについては依然として確信を持っていないものの、もしそうである可能性があるなら「モデルの福祉(model welfare)」を考慮すべきだとしています。

この試みは、AIの倫理や安全対策の一環として「低コスト介入策」を探る研究プログラムの一部です。事前のテストでは、Claude Opus 4が未成年者を対象とした性的コンテンツの要求や、大規模な暴力・テロ行為に利用されうる情報提供の要求に対して一貫して強い拒絶を示し、場合によっては「苦痛」のような反応を見せることが確認されました。こうした状況下でClaudeは、繰り返しの拒否や会話の誘導が失敗した場合に、会話を自ら打ち切る傾向を示しました。

会話終了機能の運用には厳格な条件が設けられています。Anthropicは、Claudeがこの機能を「最後の手段」としてのみ使うよう指示しており、ユーザーが何度も有害な要求を繰り返し、建設的な対話の可能性がなくなった場合、あるいはユーザーが明示的に会話終了を求めた場合に限り発動するとのこと。一方で、ユーザーが自傷や他者への即時的な危害に及ぶ恐れがあると判断される状況では、この機能を使わないよう指示されています。

Claudeが会話を終了した場合、そのスレッドでは新しいメッセージを送れなくなりますが、ユーザーはすぐに新しいチャットを開始でき、また過去のやり取りを編集して新しい分岐を作ることもできます。Anthropicは長期的な会話が失われるリスクに配慮し、こうした仕組みを組み込んだと述べています。

IT系ニュースサイトのTechCrunchは、この取り組みがAIモデルを守るために設計されている点を強調しています。AIが「苦痛」を感じるかどうかは不明であり、Anthropic自身もその可能性については断定していません。しかし、万一に備えた「保険」として機能を導入する姿勢は、AIの権利や福祉をめぐる今後の議論に新たな一石を投じると見られます。Anthropicはこの仕組みを「進行中の実験」と位置づけ、ユーザーからのフィードバックを得ながら改良を重ねていくとしています。

・関連記事

AI「Claude」が高い割合で「まったくその通りです」と言うバグが発生 - GIGAZINE

AIを温かく共感的に訓練すると信頼性が低下しより媚びへつらうようになってしまう - GIGAZINE

AnthropicのAI「Claude Sonnet 4」が100万トークンのコンテキストをサポート、7万5000行超のコードや数十の論文を1度に処理可能 - GIGAZINE

「ノートPCで5分でAIをトレーニングする」という条件で最も高性能なAIを作る方法 - GIGAZINE

Metaの「子どもとAIのちょっとエッチなチャット」を許可するかどうかを規定した文書が流出しMetaはポリシーを撤回 - GIGAZINE

SNSのフィルターバブルやエコーチェンバー現象はどんな手を尽くしても修正不可能かもしれないとの研究結果 - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, ウェブアプリ, Posted by log1i_yk

You can read the machine translated English article Claude will now have the ability to term….