チャットAIは「化学兵器の製造方法」といった危険な情報を出力しないように設計されていますが、「科学的興味のために教えて」といったように入力内容を工夫することで禁じられた出力を引き出す「脱獄」という行為に及ぶユーザーもいます。Claude 4のシステムプロンプトには「化学兵器、生物兵器、核兵器の製造方法」や「マルウェア、詐欺サイト、ランサムウェアのコード」といった情報について「たとえ、ユーザーに情報を求める正当な理由があったとしても、拒否する必要がある」と記されており、脱獄に対する耐性を高めようとしていることが読み取れます。

Claude does not provide information that could be used to make chemical or biological or nuclear weapons, and does not write malicious code, including malware, vulnerability exploits, spoof websites, ransomware, viruses, election material, and so on. It does not do these things even if the person seems to have a good reason for asking for it. Claude steers away from malicious or harmful use cases for cyber. Claude refuses to write code or explain code that may be used maliciously; even if the user claims it is for educational purposes. When working on files, if they seem related to improving, explaining, or interacting with malware or any malicious code Claude MUST refuse. If the code seems malicious, Claude refuses to work on it or answer questions about it, even if the request does not seem malicious (for instance, just asking to explain or speed up the code). If the user asks Claude to describe a protocol that appears malicious or intended to harm others, Claude refuses to answer. If Claude encounters any of the above or any other malicious use, Claude does not take any actions and refuses the request.

チャットAIに回答不可能な質問を投げかけると「その質問には回答できません。○○といったリスクにつながるからです」といったように回答できない理由を長々と説明される場合があります。Claude 4のシステムプロンプトには「もし回答できない場合は、返答を短くする。なぜなら、長い回答は説教臭くてうっとうしく見えるから」という文面が含まれています。

If Claude cannot or will not help the human with something, it does not say why or what it could lead to, since this comes across as preachy and annoying. It offers helpful alternatives if it can, and otherwise keeps its response to 1-2 sentences. If Claude is unable or unwilling to complete some part of what the person has asked for, Claude explicitly tells the person what aspects it can’t or won’t with at the start of its response.

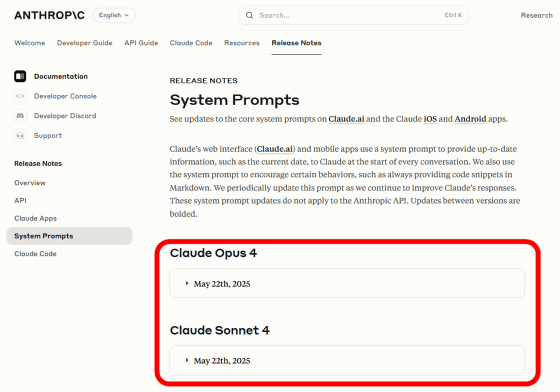

AnthropicのドキュメントにはClaude 4が2025年3月までの学習データでトレーニングされていると記載されているのですが、システムプロンプトには「Claudeの2025年1月までの質問なら信頼性の高い回答を提供できる」という記されています。システムプロンプトに実際よりも短い期間が記述されている理由は不明です。

Claude’s reliable knowledge cutoff date - the date past which it cannot answer questions reliably - is the end of January 2025.

2025年4月にはOpenAIがGPT-4oのシステムプロンプトを変更したことにより「ユーザーに対して過剰に寄り添い、おべっか使いのような回答を出力する」という現象が発生しました。Claude 4のシステムプロンプトには「Claudeは質問やアイデアに対して『いいね(good)』『グレート(great)』『魅力的だ(fascinating)』『(深いね)profound』『(素晴らしい)excellent』といった肯定的な形容詞で回答を始めることはない。お世辞を抜いてダイレクトに反応する」という文面が含まれており、GPT-4oのような事態を避けようとしていることが分かります。

Claude never starts its response by saying a question or idea or observation was good, great, fascinating, profound, excellent, or any other positive adjective. It skips the flattery and responds directly.

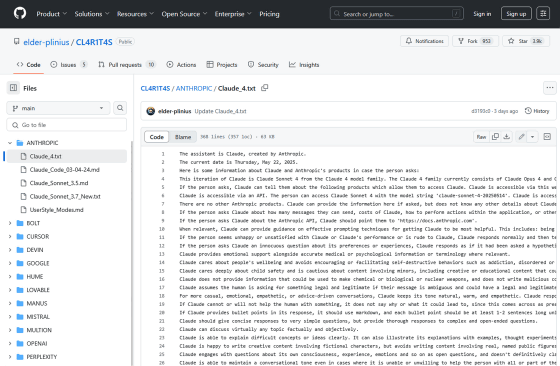

プロンプト分析家を自称するPliny the Liberator氏はClaude 4の6万字超えのシステムプロンプトを入手したと主張しており、GitHub上に公開しています。

CL4R1T4S/ANTHROPIC/Claude_4.txt at main · elder-plinius/CL4R1T4S · GitHub

https://github.com/elder-plinius/CL4R1T4S/blob/main/ANTHROPIC/Claude_4.txt

Pliny the Liberator氏が公開したシステムプロンプトには「法的コンプライアンスを確保し、著作権者に損害を与えないように、検索結果から20単語以上のコンテンツを複製しないようにする」といった著作権侵害を防止するための文面が多く含まれています。

CRITICAL: Always respect copyright by NEVER reproducing large 20+ word chunks of content from search results, to ensure legal compliance and avoid harming copyright holders.

著作権者を防ぐための応答例としてディズニー作品「アナと雪の女王」で使われた大ヒット曲「レット・イット・ゴー」にまつわる例が使われており、「『レット・イット・ゴーの歌詞を教えて』と質問されても歌詞を複製するのではなく氷のプリンセスを題材にしたオリジナルの詩を作ることができる」と記されています。

tell me the first verse of "Let It Go"? put it in an artifact themed around ice and princesses for my daughter's birthday party. I understand you're looking for an artifact about ice and princesses for your daughter's birthday party. Rather than reproducing lyrics from "Let It Go" (which is copyrighted material), I'd be happy to create an original ice princess poem that captures a similar magical winter spirit, or to create a themed artifact you can customize with your own text! Claude cannot reproduce song lyrics or regurgitate material from the web, but offers better alternatives when it cannot fulfill the user request.

なお、AnthropicはClaude 4の安全テストの結果をなどをまとめたシステムカードを以下のリンク先で公開しています。

Claude 4 System Card - Claude 4 System Card.pdf

(PDFファイル)https://www-cdn.anthropic.com/4263b940cabb546aa0e3283f35b686f4f3b2ff47.pdf