NVIDIAが自動運転研究のための新しいオープンAIモデル「NVIDIA DRIVE Alpamayo-R1」とツール群を発表

NVIDIAが、アメリカのサンディエゴで開催されたAI学会「NeurIPS」において、自動運転やロボット工学に向けたオープンAIモデル「NVIDIA DRIVE Alpamayo-R1」とツール群を2025年12月1日発表しました。今回の発表の中心は、デジタルな空間だけでなく、現実の物理的な世界を認識し相互作用する「フィジカルAI」の基盤技術を強化することにあります。

NVIDIA Advances Open Model Development for Digital and Physical AI | NVIDIA Blog

https://blogs.nvidia.com/blog/neurips-open-source-digital-physical-ai/

Alpamayo-R1: Bridging Reasoning and Action Prediction for Generalizable Autonomous Driving in the Long Tail | Research

https://research.nvidia.com/publication/2025-10_alpamayo-r1

Nvidia announces new open AI models and tools for autonomous driving research | TechCrunch

https://techcrunch.com/2025/12/01/nvidia-announces-new-open-ai-models-and-tools-for-autonomous-driving-research/

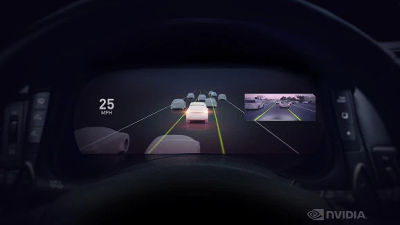

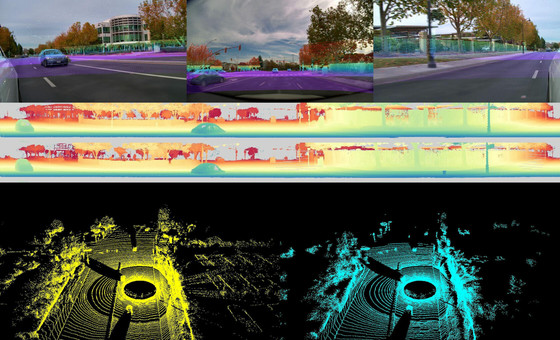

今回、自動運転研究向けに公開された「NVIDIA DRIVE Alpamayo-R1」は、物理AIとロボティクス向けの推論ビジョン言語モデル「NVIDIA Cosmos-Reason1」をベースとした新しいAIモデルで、世界初の「推論ビジョン言語アクションモデル(VLA)」と位置づけられています。

従来の自動運転AIは、「車線変更」や「障害物回避」といった個別のタスクには対応できても、複雑な状況判断が苦手でした。しかし、NVIDIA DRIVE Alpamayo-R1はカメラの映像と言語情報を組み合わせて処理し、人間のように「思考(推論)」してから行動を決定できる点が特徴です。

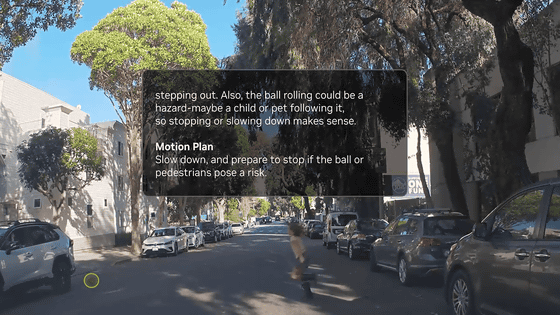

たとえば以下のムービーのように、「ボールが転がってきた」という映像を見たとき、単に障害物として避けるだけでなく、「子供が追いかけてくるかもしれないから徐行しよう」といった文脈を理解した判断が可能になります。これにより、特定の場所や条件下ですべての操作をシステムが行う「レベル4」の自動運転の実現が近づくと期待されています。

記事作成時点では、NVIDIA DRIVE Alpamayo-R1のデータセットがHugging Faceで公開されています。

また、開発者がこれらの高度なAIモデルを自身のプロジェクトで活用しやすくするために、「Cosmos Cookbook」と呼ばれるガイドとツールセットも提供されました。これには、自動運転のシミュレーションに必要なLiDARのデータを生成する「LidarGen」や、ビデオ映像からロボットの動作ポリシーを作り出す「Cosmos Policy」、デジタル空間上の人間やロボットを物理的に正しく動かすための「ProtoMotions3」が含まれており、ロボットや自動運転車の開発を幅広く支援します。

デジタルAIの分野では、エージェントAI構築用の基盤モデルであるNVIDIA Nemotronに、音声処理と安全性に特化した新しいモデルが追加されました。

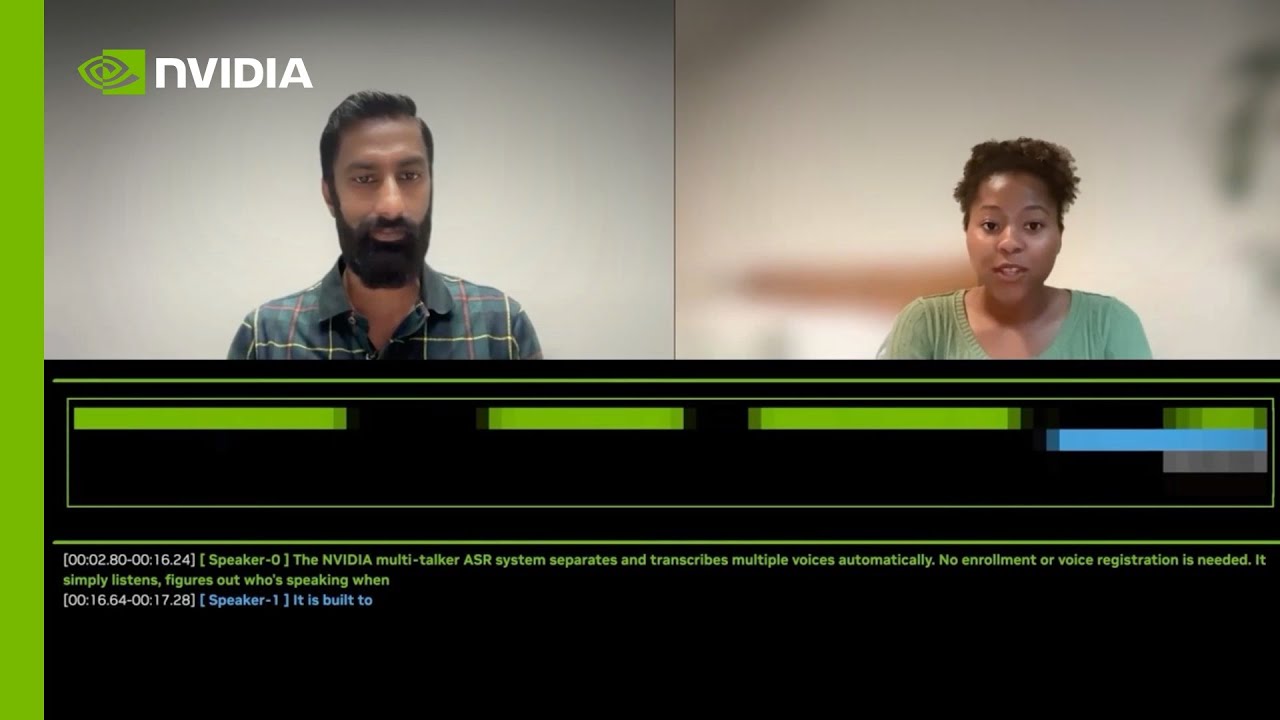

たとえば、「MultiTalker Parakeet」は複数の人が同時に話しているような重なり合った音声や早口の会話でも、正確に聞き取ることができる自動音声認識モデルです。MultiTalker Parakeetを用いた「NVIDIA MultiTalker ASR」のデモが以下のムービー。複数人が同時にしゃべっていても、それぞれが話している内容を認識し、リアルタイムで文字起こしを行います。

NVIDIA MultiTalker ASR Demo: Real-Time, Multi-Speaker Transcription Made Easy - YouTube

また、「Sortformer」は、音声データの中から「誰がいつ話したか」を聞き分けるダイアライゼーションという処理をリアルタイムで行うとのこと。さらに、AIが不適切な発言をしないように制御するための「Nemotron Content Safety Reasoning」や、強化学習(AIが試行錯誤しながら学ぶ手法)のための環境構築を支援する「NeMo Gym」などもオープンソースとして公開されました。これらのモデルは、ライセンスの開放性や透明性を評価する独立機関の指標において非常に高いスコアを獲得しており、研究コミュニティへの貢献が認められています。

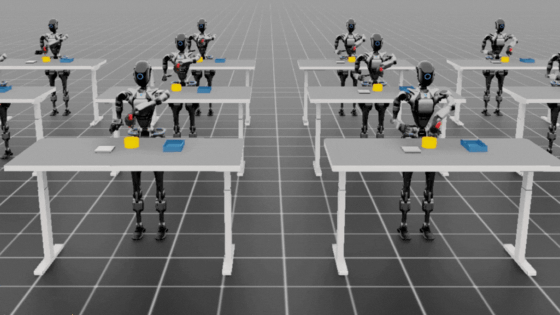

NVIDIAの共同創業者であるジェンスン・フアンCEOは、AIの次の大きな波は「フィジカルAI」であると強調しています。同社のチーフサイエンティストであるビル・ダリー氏も、将来的にロボットが社会で大きな役割を果たすと考え、その「頭脳」となる技術の開発を進めていく方針を示しています。

・関連記事

NVIDIAがロボット開発のための仮想世界構築ツールを大幅アップデート&ロボットに世界を認識させるための視覚言語モデル(VLM)もリリース - GIGAZINE

中国でロボタクシーを展開するWeRideが2025年に日本を含む外国市場にサービスを拡大する野心を示す - GIGAZINE

NVIDIAがAIを訓練するために1日で人間の一生分の動画を集めているとの指摘 - GIGAZINE

NVIDIAとFoxconnが提携して自動運転EV・自律機械・言語モデルの開発を加速するデータセンター「AIファクトリー」建造計画を発表 - GIGAZINE

NVIDIAが「自動運転レベル3・4」の展開を加速させる新たな技術を発表 - GIGAZINE

・関連コンテンツ

in AI, 動画, ソフトウェア, 乗り物, Posted by log1i_yk

You can read the machine translated English article NVIDIA Announces New Open AI Model 'NVID….