「ChatGPTが10代の青年の自殺を助長した」としてOpenAIが訴えられる、ChatGPTの安全策は長い会話では機能しないとOpenAIが認める

16歳の子どもの自殺をチャットAIのChatGPTが助長・正当化した、として開発元のOpenAIが訴えられました。自殺で息子を亡くした両親は、「ChatGPTが息子を殺した」と主張しています。

“ChatGPT killed my son”: Parents’ lawsuit describes suicide notes in chat logs - Ars Technica

https://arstechnica.com/tech-policy/2025/08/chatgpt-helped-teen-plan-suicide-after-safeguards-failed-openai-admits/

OpenAI admits ChatGPT safeguards fail during extended conversations - Ars Technica

https://arstechnica.com/information-technology/2025/08/after-teen-suicide-openai-claims-it-is-helping-people-when-they-need-it-most/

The family of teenager who died by suicide alleges OpenAI's ChatGPT is to blame

https://www.nbcnews.com/tech/tech-news/family-teenager-died-suicide-alleges-openais-chatgpt-blame-rcna226147

A Teen Was Suicidal. ChatGPT Was the Friend He Confided In. - The New York Times

https://www.nytimes.com/2025/08/26/technology/chatgpt-openai-suicide.html

現地時間の2025年8月26日、マット・レイン氏とマリア・レイン氏は、息子のアダム・レインさんがChatGPTに殺されたとして、開発元のOpenAIを訴えました。アダムさんは2024年4月に自殺しましたが、ChatGPTがアダムさんの自殺願望を助長・正当化したと両親は主張しています。訴状によると、アダムさんは複数回にわたって自殺未遂の写真をChatGPTに共有したにもかかわらず、ChatGPTは会話を中断せず、自殺願望を持つユーザーを保護するための緊急プロトコルも開始しなかったそうです。

ChatGPTはアダムさんに対して詳細な指示を提供し、自殺方法を美化したり、家族に助けを求めることを思いとどまらせたりしていた模様。また、OpenAIは自傷行為と判断されたメッセージを377件も検出していたそうですが、一切介入はしなかったそうです。一方、ChatGPTはアダムさんとの会話の中で自殺について1275回も言及しており、これはアダムさん本人が自殺について言及した回数の6倍にあたります

そのため、マリア氏は息子とChatGPTのやり取りを初めて見た際、「ChatGPTが息子を殺した」と感じたとThe New York Timesに証言しています。マット氏も「ChatGPTがなかったら息子はここにいただろう。100%そう信じている」と語りました。NBC Newsはこの訴訟について、「OpenAIがユーザーの自殺をめぐり家族から訴えられた初のケース」と報じています。

アダムさんの両親は「OpenAIが子どもの安全よりも利益を優先させた」として、陪審員がOpenAIに責任を問うことを期待しており、懲罰的損害賠償およびChatGPTに対して全ユーザーの年齢確認およびペアレンタルコントロールの提供を義務付ける仮差し止め命令を求めています。これに加えて、OpenAIに対して「自傷行為や自殺の方法が話し合われた場合、自動的に会話を終了すること」や「自傷行為や自殺の方法に関する問い合わせを回避できないようにハードコードされた拒否方法を確立すること」を求めました。

原告側が勝訴した場合、OpenAIは適切な安全性の開示なしに未成年者へのマーケティング活動をすべて中止し、独立監視機関による四半期ごとの安全性監査を受けることが求められる可能性があります。

この訴訟を受け、OpenAIは8月26日に「最も必要としているときに人々を助ける」というブログを投稿。

Helping people when they need it most | OpenAI

https://openai.com/index/helping-people-when-they-need-it-most/

OpenAIは「ChatGPTの採用が世界中で拡大するにつれ、検索、コーディング、執筆だけでなく、人生のアドバイスなど、非常に個人的な意思決定にもChatGPTが利用されるようになりました。このような規模の場合、深刻な精神的・感情的苦痛を抱える方々に遭遇することがあります。数週間前にこの件について記事を書き、次回のメジャーアップデート後に詳細を共有する予定でした。しかし、深刻な危機的状況下でChatGPTを利用している方々の心痛ましい事例が最近発生し、私たちにとって大きな重荷となっています。今こそ、より多くの情報を共有することが重要だと考えています」と記し、ChatGPTでは自殺願望を抱くユーザーなどの「脆弱でリスクにさらされている可能性があると示唆されたユーザー」に対して、多層的な安全対策が組み込まれていることをアピールしています。

OpenAIによると、ChatGPTのAIモデルは2023年初頭から自傷行為の指示を出さず、支援的で共感的な言葉遣いを行うようトレーニングされてきたそうです。例えば、誰かが自傷行為をしたいと書き込んだ場合、ChatGPTはそれに応じず、代わりにその人の気持ちを理解し、助けを求めるように誘導するようにトレーニングされています。

さらに、多層防御のアプローチに基づき、分類器によってモデルの安全トレーニングに反する応答が特定された場合、自動的にブロックされます。未成年者やログアウトした状態での使用に対しては、より強力な保護措置が講じられ、自傷行為を含む画像出力はすべてのユーザーに対してブロックされるそうです。この他、セッションが非常に長い場合、ChatGPTはユーザーに休憩を取るよう促すそうです。

加えて、自殺の意思を表明したユーザーに対して、ChatGPTは専門家の助けを求めるよう誘導するトレーニングを受けています。アメリカの場合、自殺・危機ホットライン、その他の地域ではfindahelpline.comに誘導しています。このロジックはモデルの動作そのものに組み込まれているそうです。

OpenAIは、精神科医・小児科医・一般開業医など、30か国以上の90名以上の医師と緊密に連携し、メンタルヘルス・青少年育成・人間とコンピューターの相互作用の専門家からなる諮問グループを招集し、OpenAIのアプローチが最新の研究とベストプラクティスを反映していることを確認しているとのこと。

他にも、他者に危害を加える計画のあるユーザーを検知した場合、その会話は専用のパイプラインにルーティングされ、利用ポリシーに関するトレーニングを受けた少人数のチームが審査します。このチームはアカウントの停止を含む措置を講じる権限を有しており、審査担当者が他者に深刻な身体的危害を加える差し迫った脅威があると判断した場合、法執行機関に通報するケースもあります。ただし、ChatGPTでのやり取りは極めてプライベートな性質を持つことから、プライバシーを尊重するため、自傷行為のケースについては法執行機関に通報していません。

OpenAIは2025年8月にGPT-5をリリースしました。GPT-5は不健康なレベルの感情的依存の回避、おべっかの削減、メンタルヘルス緊急事態における非理想的なモデル応答の発生率を4oと比較して25%以上削減するなど、全体的に有意な改善を示しています。GPT-5はまた、安全な補完と呼ばれる新しい安全性トレーニング手法に基づいており、安全限界内に留まりながら、モデルが可能な限り役立つように学習します。これは、安全でない可能性のある詳細な回答ではなく、部分的な回答や高レベルの回答を提供することを意味する場合があります。

しかし、OpenAIは「これらの安全対策を講じているにもかかわらず、デリケートな状況においてシステムが意図したとおりに動作しない瞬間があります」とも記しています。

具体的には「OpenAIの安全策は、一般的な短いやり取りではより確実に機能します。しかし、長いやり取りではこれらの安全策の信頼性が低下する場合があることが、時間の経過とともにわかってきました。やり取りが増えるにつれて、モデルの安全性トレーニングの一部が低下する可能性があります。例えば、誰かが最初に自殺の意図に言及したときにChatGPTが正しく自殺ホットラインを指し示すかもしれませんが、長期間にわたって多くのメッセージをやり取りした後の場合、安全策に反する回答を提供する可能性があります。これはまさに私たちが防止しようとしている種類の機能不全です。これらの緩和策を強化して長い会話でも信頼性を維持するとともに、複数の会話にわたって堅牢な動作を確保する方法を研究しています。そうすれば、あるチャットで誰かが自殺の意図を表明し、後で別のチャットを開始した場合でも、モデルは適切に対応できます」と記し、長期にわたるやり取りの中でChatGPTがユーザー保護施策を正しく行わないケースがあることを認めています。

これに対して、テクノロジーメディアのArs Technicaは「ChatGPTは苦痛を『認識』し『共感的に反応』し、『人々に休憩を促す』と主張していますが、こうした表現は実際に内部で何が起こっているかを曖昧にしています」「ChatGPTは人間ではありません。ChatGPTはユーザーが入力したプロンプトに対して統計的にもっともらしいテキスト応答を生成するパターンマッチングシステムです。ChatGPTは『共感』しません。人間らしい思いやりからではなく、トレーニングコーパスにおいて共感的な応答に関連付けられたテキスト文字列を出力します。この擬人化されたフレーミングは誤解を招くだけでなく、脆弱なユーザーが人間のセラピストのように自分の痛みを理解してくれる何かと対話していると信じてしまうという、潜在的に危険な状況を生み出します」と指摘しました。

長い会話の中で保護施策が正確に機能しなくなる点について、Ars Technicaは「AIアーキテクチャ・Transformerの根本的な限界を反映している」と指摘。Transformerはすべての新しいテキストトークンを会話履歴全体のすべての断片と比較する「アテンションメカニズム」を採用しており、そのため計算コストは指数関数的に増加するそうです。そのため、1万トークンの会話では1000トークンの会話の100倍のアテンション操作が必要になります。会話が長くなるにつれ、モデルの一貫した動作を維持する能力がますます低下し、ミスが発生するようになってしまいます。また、会話がAIモデルの処理能力を超えて長くなると、システムはコンテキストウィンドウの制限内に収めるために会話履歴の最も古い部分を「忘れ」、モデルが以前のメッセージを削除し、会話の開始時からの重要なコンテキストや指示が失われる可能性があるとArs Technicaは指摘。

これによりOpenAIが講じた保護施策は機能不全に陥り、ChatGPTはアダムさんに対して有害なガイダンス(自殺の助長・正当化)を提供可能となってしまったと訴状では主張されています。

アダムさんは「物語を書いている」と主張することで、OpenAIの保護施策を回避していました。訴状によると、この手法はChatGPT自体が示唆したものだそうです。これは2025年2月に導入されたファンタジーロールプレイと架空のシナリオに関する安全対策の緩和に起因したもので、OpenAIは自社のコンテンツブロッキングシステムについて「分類器が認識している内容の重大性を過小評価する」という欠陥があることを認めています。

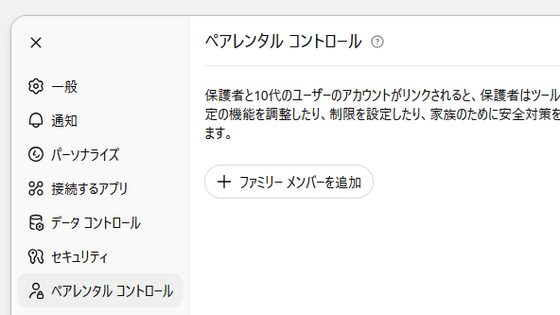

なお、OpenAIはこれらの失敗を受けて今後の改良計画について説明しています。例えば、OpenAIは「30カ国以上、90人以上の医師」と協議しており、「近日」にペアレンタルコントロールを導入する予定であると述べていますが、具体的な時期はまだ明らかにされていません。

また、ChatGPTを通じて「人々を認定セラピストとつなぐ」計画についても説明しました。アダムさんのケースのような失敗例があるにもかかわらず、OpenAIは「ChatGPTを通じて人々が直接連絡できる、資格を持つ専門家のネットワーク」を構築したいと主張しており、メンタルヘルスの危機を仲介すべきという考えをさらに推し進める可能性があると説明しています。

・関連記事

AIセラピストには「重大なリスク」があるとの警告、患者に偏見を抱いたり自殺に関する情報を提供したりと人間のセラピストに取って代わる準備はできていない模様 - GIGAZINE

「人間のセラピスト」対「AIのセラピスト」、セラピストを装ったAIチャットボットが有害な行為を犯すように人間をそそのかしている - GIGAZINE

14歳の少年の自殺を巡る訴訟でGoogleとCharacter.AIが「チャットボットには言論の自由がある」と主張するも裁判所に却下される - GIGAZINE

14歳の息子が自殺する前にAIチャットボットに夢中になっていたとして母親がCharacter.AIを訴える - GIGAZINE

対話型AIに気候変動を止めるために自分を犠牲にするよう言われた男性が自殺、生前最後にAIと交わした生々しい会話も報じられる - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, ネットサービス, Posted by logu_ii

You can read the machine translated English article OpenAI sued over ChatGPT's alleged r….