OpenAIが「Google製AIチップを採用する予定はまだない」と表明、初期段階のテストは実行中

OpenAIがGoogle製AIチップ「TPU」をAIの推論に採用するべく動き始めたことが2025年6月末に報じられましたが、新たにOpenAIが「現時点ではTPUを大規模に展開する計画はない」と表明しました。

OpenAI says it has no plan to use Google's in-house chip | Reuters

https://www.reuters.com/business/openai-says-it-has-no-plan-use-googles-in-house-chip-2025-06-30/

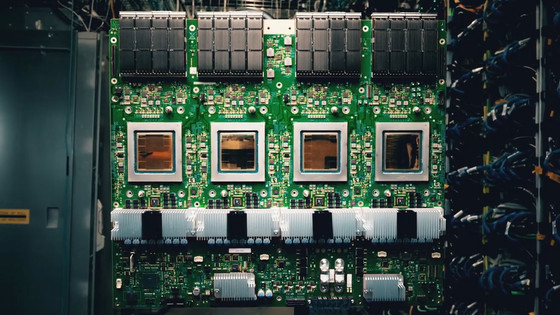

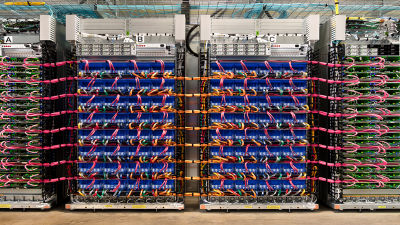

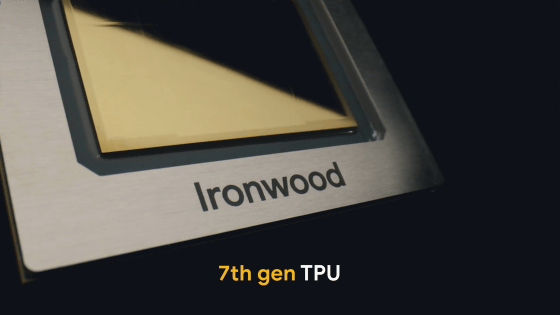

Googleは2010年代から機械学習に特化したプロセッサの開発に取り組み始め、2016年に機械学習特化プロセッサ「Tensor Processing Unit(TPU)」の存在を公表しました。TPUは2017年にはGoogleのクラウドサービスを介して一般ユーザー向けにも提供され始め、定期的に世代更新が発表されています。2025年4月に登場した第7世代TPU「Ironwood」は1チップ当たり192GBのメモリを搭載し、処理速度は1チップ当たり4614TFLOPSに到達。これにより、各種推論モデルの高速実行が可能になったことがアピールされています。

Googleが推論モデルの処理に最適化した第7世代TPU「Ironwood」を発表、1チップ当たり192GBのメモリを搭載し1ポッド当たりの性能は最強スパコン「El Capitan」の24倍以上 - GIGAZINE

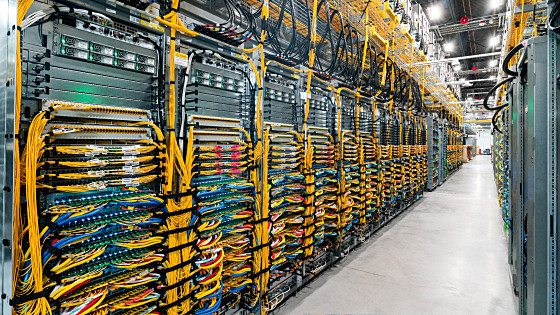

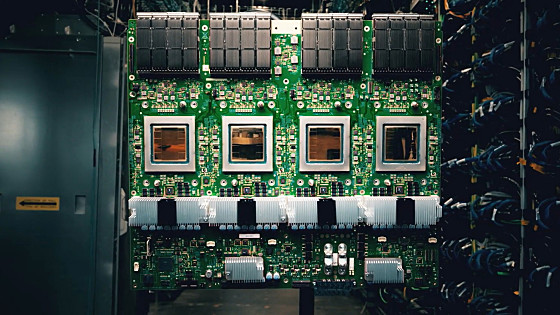

OpenAIはNVIDIAの大口顧客として知られており、H100やH200といったNVIDIA製AIチップを大量に購入して大規模なAIインフラストラクチャーを構築しています。そんなOpenAIが自社製AIを処理するためにGoogleのTPUをレンタルし始めたことが2025年6月28日にロイターによって報じられました。この際、ロイターは「この契約は、Googleにとって内部使用に限定されていたTPUの外部利用を拡大する動きの一環であり、OpenAIにとってNVIDIA以外のチップを意味ある形で初めて使用するものになる。OpenAIは、Microsoftのデータセンターへの依存から離れる姿勢を示した」と指摘していました。

OpenAIがChatGPTなどの推論処理にGoogleのTPUを使用開始したとの報道、NVIDIA以外のAI処理チップを使うのは初 - GIGAZINE

その後、2025年6月30日にOpenAIの広報担当者がロイターに対して「OpenAIの研究所ではGoogleのTPUを用いた初期段階のテストを実行している。しかし、現時点ではTPUを大規模に展開する計画は存在しない」という声明を発表しました。これによりOpenAIがTPUのテストを進めていることが事実であることが判明したものの、実際の製品でTPUが使われる段階にあるわけではないことも明らかになりました。ただし、Googleはコメントを控えています。

NVIDIAはロイターの報道を受けて「今後もOpenAIとのコラボを通じてAIの未来を共に形作っていきます」とコメントしています。

Here’s to our ongoing collaboration with @OpenAI, as we continue to shape the future of AI together.https://t.co/123x2JqRVb

— NVIDIA Newsroom (@nvidianewsroom) July 2, 2025

・関連記事

OpenAIがChatGPTなどの推論処理にGoogleのTPUを使用開始したとの報道、NVIDIA以外のAI処理チップを使うのは初 - GIGAZINE

MicrosoftがOpenAIとの交渉から撤退の準備を開始か - GIGAZINE

NVIDIAのジェンスン・フアンCEOが「H200」搭載AIシステムをOpenAIのサム・アルトマンCEOに直接手渡す - GIGAZINE

Googleが推論モデルの処理に最適化した第7世代TPU「Ironwood」を発表、1チップ当たり192GBのメモリを搭載し1ポッド当たりの性能は最強スパコン「El Capitan」の24倍以上 - GIGAZINE

Googleが第6世代TPU「Trillium」発表、TPU v5eよりも1チップ当たり4.7倍優れたパフォーマンスと67%優れたエネルギー効率でGoogle CloudのAIを支える - GIGAZINE

Googleが機械学習を爆速化する専用の「TPU」を数年前から極秘裏に作っていたことが明らかに - GIGAZINE

・関連コンテンツ

in ハードウェア, Posted by log1o_hf

You can read the machine translated English article OpenAI has announced that it has no plan….